di Giambattista Amati, Ricercatore FUB della Direzione Scientifica, esperto di data science, big data e AI

L’affermazione dell’intelligenza artificiale (AI) pone ogni organizzazione davanti a sfide cruciali: compiti automatizzabili, integrazione nei processi, implicazioni etiche e legali. Le prospettive sono molteplici e complesse, come mostrano anche le elaborate linee guida dell’AGID e quelle più sintetiche del MIT.

La varietà di angolazioni da cui osservare l’AI rende arduo il compito di risolverne le implicazioni in modo sistematico e razionale. Per esempio, le linee guida dell’Agenzia per l’Italia Digitale redatte per le Pubbliche Amministrazioni sono estremamente dettagliate e potrebbero scoraggiare le P.A. più innovative dal promuoverle per una piena integrazione dell’AI finalizzata al miglioramento dei servizi. L’osservazione è ancora più fondata se le confrontassimo con quelle molto semplificate messe in atto da un’università americana tecnologicamente avanzata come il Massachusetts Institute of Technology.

Mappa mentale delle linee guida dell’AGID create da notebookLM di Google

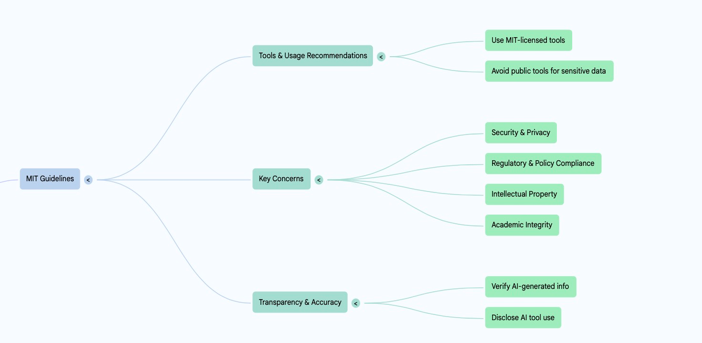

Mappa mentale delle linee guida dell’MIT generata da notebookLM di Google.

Un’organizzazione come la Fondazione Ugo Bordoni, consapevole della complessità delle P.A. e che vanta competenze scientifiche e tecnologiche consolidate in diversi ambiti dell’innovazione, ora ha l’opportunità di raccogliere le sfide poste dall’intelligenza artificiale, fornendo delle risposte tempestive e concrete. Le soluzioni potrebbero arrivare soprattutto dalle idee dei giovani talenti motivati e con visioni originali e all’avanguardia, che rappresentano nell’attuale contesto la spinta propulsiva al cambiamento.

Nel workshop interno sul tema dell’AI che si è svolto recentemente sono già state presentate alcune nuove idee e ipotesi di servizi innovativi. Sebbene tali proposte siano al momento ancora allo stato embrionale, potrebbero essere ampliate offrendo alla Fondazione Ugo Bordoni la possibilità di sfruttare appieno il potenziale dell’intelligenza artificiale, nonché posizionarsi tra i punti di riferimento a livello nazionale a cui guardare per l’integrazione dell’AI nei processi produttivi e nella ricerca.

Come funziona l’AI generativa autoregressiva: potenzialità, limiti e rischi

Il primo passo è comprendere a fondo come funziona l’AI al fine di svolgere una corretta valutazione dei rischi connessi. Perché l’AI funziona molto bene con i linguaggi formali (per esempio nella generazione di codice), mentre risulta ancora molto rischiosa nella generazione di contenuti tecnici e scientifici, anche a causa di frequenti “allucinazioni”? Gli attuali sistemi di AI, ovvero i Large Language Model (LLM), si basano su modelli autoregressivi, che generano una parola alla volta scegliendola da un insieme di parole probabili e utilizzando miliardi di parametri. Per rendere la macchina più creativa e meno deterministica, si introduce un elemento di aleatorietà (tecnicamente il parametro “temperatura”), che rende questa scelta più o meno prevedibile e apparentemente più creativa. Per generare codice il sistema imposta automaticamente una temperatura bassa, ossia sceglie sempre la parola più probabile come successiva, mentre per la generazione di testo usa una temperatura più alta. In sostanza, se avessimo la possibilità di sottomettere milioni di volte una stessa richiesta (prompt), otterremmo milioni di risposte sempre diverse. Va da sé che la macchina, grazie a miliardi di parametri, è sempre in grado di recuperare pattern nella sua memoria che le permettano di collegare due concetti anche molto distanti tra loro proposti dall’utente e l’allucinazione in questo caso diventa più probabile.

Freshness dei dati di addestramento degli LLM

Un altro limite dei modelli LLM riguarda gli aggiornamenti dei parametri, che avvengono poco frequentemente. Per esempio, attualmente ChatGPT non ha accesso diretto a eventi successivi alla data del suo ultimo aggiornamento, rendendo la conoscenza su cui è avvenuto il suo addestramento datata di oltre un anno. Gli LLM non conservano dati in modo strutturato o esplicito e di conseguenza il recupero preciso di informazioni risulta spesso soggetto a errori (per esempio la proprietà commutativa dell’uguaglianza). Tuttavia, poiché l’architettura è fortemente basata sullo scaling-up, dove la capacità di ragionamento determinata dal numero di parametri e il processo di addestramento risultano indissolubilmente legati, emergono evidenti problemi di aggiornamento che non possono essere risolti semplicemente ricorrendo al fine-tuning, ovvero a quel raffinamento incrementale dei parametri esistenti ottenuto attraverso l’aggiunta di nuove informazioni.

Sebbene esistano tecniche avanzate per il fine-tuning dei LLM (come ZeRO o LoRA), ChatGPT non adotta un approccio di aggiornamento incrementale. Il fine-tuning risulta estremamente costoso per risorse computazionali e memoria. Inoltre, gli aggiornamenti frequenti potrebbero introdurre instabilità nel sistema come il catastrophic forgetting. Risulta complesso mantenere coerenza tra apprendimento di nuovi dati e conoscenze pregresse. Di conseguenza, ogni eventuale aggiornamento richiederebbe una fase di validazione particolarmente accurata per scongiurare possibili riduzioni nell’accuratezza del modello.

Come ovviare in parte alle allucinazioni: il fact-cheking come risorsa

Per ovviare a questa limitazione, ChatGPT ricorre al cosiddetto Retrieval-Augmented Generation (RAG), effettuando ricerche sul web che dovrebbero ridurre le allucinazioni ed evitare affermazioni obsolete. Ma il web non è sempre una fonte affidabile. Pertanto, i documenti tecnici prodotti con l’AI comportano un rischio molto elevato di contenere affermazioni non supportate adeguatamente. Ed è qui che entra in gioco l’etica e la trasparenza: risulta imprescindibile dichiarare le finalità dell’utilizzo dell’AI, specificando se sia stata limitata all’attività di revisione grammaticale e stilistica (riformulazione) o se sia stata sfruttata anche nell’attività di ricerca/scouting dei contenuti. In quest’ultimo caso sarà d’obbligo procedere con il fact-checking, verificando accuratamente tutte le affermazioni generate dall’AI, nessuna esclusa. In sostanza queste accortezze sono proprio quelle richieste dalle linee guida, che siano state rilasciate dall’AGID o dall’MIT.

Servizi AI general-purpose: meglio in cloud o in locale?

L’impiego dell’AI nelle attività lavorative produce benefici che hanno un significativo impatto sulla produttività. Il primo obiettivo è quindi comprendere come integrare i servizi AI based general-purpose. È possibile inizialmente ricorrere ai servizi a pagamento in cloud, come per esempio le chat degli LLM (ChatGPT, Gemini o Claude), sebbene anche le versioni gratuite di tali servizi offrano al momento un numero generoso di interrogazioni.

Per un ente di ricerca come la Fondazione Ugo Bordoni appare fondamentale acquisire un motore di ricerca scientifica basato sull’AI come SciSpace per raccogliere, esplorare, analizzare e comporre più velocemente lo stato dell’arte su un argomento scientifico. Sarebbe inoltre opportuno dotarsi di notebookLM per riassumere e “chattare”, ovvero interrogare in modo interattivo un insieme di documenti e circoscriverne la lettura. Analogamente potrebbero essere acquisite diverse soluzioni per supportare la generazione di codice, che hanno dimostrato buone performance.

Soluzioni open-source per l’AI: Hugging Face e Ollama

Ma cosa fare se alcuni documenti, codici o dati fossero proprietari e sensibili o se sorgano invece esigenze di servizi analoghi, ma in locale e offline? E ancora, quali sono i trade-off in termini di efficacia e costi tra l’acquisto di servizi su cloud forniti dalle BigTech americane e la predisposizione di soluzioni open-source, on-premises e offline?

Per seguire la strada dell’open-source come alternativa ai servizi a pagamento è possibile ricorrere a due piattaforme per sviluppare progetti basati sull’elaborazione del linguaggio naturale o sull’AI e il machine learning, che hanno obiettivi e funzionalità differenti: Hugging Face e Ollama. La prima offre l’infrastruttura software e architetturale completa per lo sviluppo di un LLM da zero, ospitando anche un archivio di modelli pre-addestrati utili per compiti come la classificazione, la traduzione o il riassunto dei testi, nonché il supporto per sviluppare servizi su cloud. Ollama, invece, più recente, è finalizzata all’esecuzione in locale e offline dei modelli linguistici di grandi dimensioni in formato aperto (open-weight models), rendendo semplice l’installazione e l’utilizzo sull’hardware locale. Nel caso di vincoli di privacy o di sicurezza o più in generale dell’esigenza di un uso dei LLM offline, Ollama appare una soluzione più adeguata, poiché i modelli vengono eseguiti localmente. Esistono librerie come vLLM, Text Generation Inference (TGI), che massimizzano il throughput (numero di richieste al secondo) e la scalabilità per un singolo modello base, anche con migliaia di richieste concorrenti.

Si dovrà inoltre prevedere l’istituzione di diversi layer di elaborazione dell’inferenza, per esempio utilizzando KServe per applicazioni sensibili alla latenza e per interfacciarsi a orchestratori come Kubernetes o Ray, al fine di scalare e distribuire il calcolo su più cluster GPU. Inoltre, se si intende raffinare i modelli pre-addestrati su documenti proprietari (fine-tuning) esistono altri progetti open-source, come LoRA eXchange (LoRAX), che consentono agli utenti di gestire migliaia di modelli fine-tuned su una singola GPU, riducendo drasticamente i costi di servizio offline e on-premises, senza compromettere throughput o latenza.

In breve, sarebbe opportuno svolgere una valutazione approfondita sulla modalità di generazione dei servizi open-source efficaci ed efficienti in locale, includendo l’analisi dei costi e benefici di entrambe le soluzioni: su cloud a pagamento e open-source in locale. Ad ogni modo, l’offerta open-source è in continua crescita e occorrerebbe predisporre un vero e proprio osservatorio che indirizzi le organizzazioni, le PMI e soprattutto le P.A. verso una scelta ponderata e consapevole in base alle proprie esigenze.

Verso l’automazione della data science: tecniche e strumenti disponibili

Passiamo a esaminare la situazione dal punto di vista dell’analisi dei dati. Qualche anno fa nessuno avrebbe scommesso che le figure altamente qualificate nel mercato del lavoro come i professionisti STEM o i data scientist sarebbero state minacciate dall’automazione. Eppure, oggi è possibile accedere a CoLab di Google, allegare un file di dati e usare Gemini per svolgere in sequenza ininterrottamente più di una decina di processi in automatico che una volta venivano svolti manualmente dal data scientist. Per ciascuno di questi passi si produce anche il codice relativo in python (in chunk del notebook Jupyter). Anche quando Gemini non è in grado di fornire immediatamente la soluzione, il data scientist ha la possibilità di procedere a raffinamenti successivi del codice già prodotto, interagendo in tutto o in parte con l’LLM di Google. I passi che un data scientist compie nell’elaborazione di un modello di machine learning o di AI di analisi dei dati sono molteplici: data loading, exploration, cleaning, wrangling e analysis, a seguire feature engineering e visualization, model training e evaluation, model optimization e infine la presentazione dei risultati. Anche se ciascuno dei passi illustrati necessita di tecniche specifiche, il data scientist percorre spesso le stesse strade e la macchina ha imparato a fare lo stesso. Per esempio, dopo la fase di feature engineering – ovvero di individuazione delle caratteristiche essenziali da inserire nel modello – si applicano un certo numero di modelli come quelli di regressione, Random Forest o XGBoost. Infine, si sceglie quello più efficace e lo si raffina. Il percorso per una completa automazione della data science è dunque già avviato.

Gestione di dataset eterogenei: possibili soluzioni oltre gli LLM

Vediamo cosa succede nel caso in cui si abbiano tanti dataset diversi come, per esempio, i dati di un sito di e-commerce, con gli utenti da un lato e i prodotti dall’altro. Anche per questo caso più complicato da gestire possiamo affidarci a una nuova linea di ricerca che si chiama Relational Deep Learning (RDL). Mettere in comunicazione database diversi ed eterogenei (per esempio i dati open del Ministero dell’Economia e delle Finanze o di Istat o del Ministero degli Interni), a volte realizzati da soggetti diversi, non è una cosa semplice. La capacità di analizzare e integrare dataset di natura diversa, ma che condividano chiavi di lettura collegate, è stata una promessa mancata dell’era dei big data. Oggi con l’uso degli LLM abbiamo la possibilità di riprendere questo filone e incrociare dati più agevolmente, essendo tali linguaggi in grado di far parlare, collegare e analizzare dataset diversi. Uno spin-off dell’Università di Stanford KumoAI, già valutato 250 milioni di dollari, ha intrapreso proprio la strada dell’automazione completa del lavoro del data scientist, ma con un approccio diverso dallo strumento offerto da Gemini in CoLab, ovvero utilizzando il deep learning come “modello” universale predittivo.

I dati di un’organizzazione come asset strategico da valorizzare

Come abbiamo visto, l’AI può fornirci supporto nell’esplorare e scandagliare in modo più efficiente dati numerosi e complessi, fornendo predizioni. Oltre ai task tipici di predizione, spesso l’obiettivo primario del data scientist è quello di ottimizzare. L’ottimizzazione è quasi sempre affrontata da algoritmi di complessità non trattabile, ossia algoritmi che – spesso in presenza di dati complessi – non sono in grado di fornire una soluzione a causa dei tempi proibitivi o risorse computazionali limitate. Poiché l’AI può apprendere, ovvero approssimare una qualsiasi funzione attraverso un Multi-Layer Perceptron e tramite architetture più complesse come i Transformer, si potrebbe ipotizzare di imparare direttamente dagli ottimizzatori e fornire comunque una risposta, soprattutto in tempi rapidi. Questa nuova frontiera dell’AI si chiama Learning To Optimize (L2O). Esiste inoltre un nuovo filone dell’analisi dati che utilizza i Graph Neural Network (GNN) per modellare i dati. È stato già accennato precedentemente a una sua applicazione al RDL. Più in generale, laddove esiste una rete – che sia sociale, di comunicazione, relativa a componenti chimici o al genoma, finanziaria o commerciale – è possibile applicare le reti neurali a queste tipologie di domini. Nell’ambito dei progetti finanziati con i fondi PNRR di RESTART la Fondazione Ugo Bordoni sta affrontando problemi di ottimizzazione della comunicazione veicolare con un approccio L2O, considerando proprio alcune particolari architetture di GNN. Ma il caso di studio veicolare non è vincolante. Queste nuove tecnologie possono essere applicate in qualsiasi settore, soprattutto nelle telecomunicazioni. L’analisi testuale, che paradossalmente è la più semplice da formalizzare (trattandosi di una sequenza di token), ha ricevuto notevole attenzione da parte dei ricercatori e dell’industria Big Tech, beneficiando in tal modo di maggiori risorse. Tuttavia, le GNN occuperanno sempre più spazio e attenzione grazie alle loro potenzialità applicative. Assisteremo sicuramente allo sviluppo di architetture sempre migliori e a una crescente qualità della ricerca, rendendo questo settore proficuo quanto l’AI generativa applicata al testo.

Cos’altro l’AI potrà rivoluzionare? Dal vector search ai nuovi motori semantici

Il primo passo per applicare l’AI è quello di “vettorizzare” la struttura dei dati che si intendono trattare, che siano testo, immagine, video o grafo. Una volta che l’oggetto è stato rappresentato da un vettore (embedding), diventa possibile apprendere qualsiasi funzione di trasformazione dei dati mediante un’architettura di rete neurale, facendo per esempio machine translation o addirittura generare testo. L’embedding permette che oggetti simili abbiano rappresentazioni vicine. Quindi in molti problemi pratici che prevedono un numero molto grande di osservazioni, potremmo semplicemente recuperare le soluzioni più vicine (l’output) a un qualsiasi dato di input, senza la necessità di fare calcoli. Il recupero efficiente di questi vettori si chiama vector search. Esistono già software open source come Chroma DB che svolgono tali funzioni. Ma l’applicazione principale riguarderà i motori di ricerca. Attualmente l’indicizzazione dei motori di ricerca è ancora basata sulla tecnologia del file invertito. L’indicizzazione avviene annotando per ogni documento i token occorrenti e in seguito viene costruito un file che restituisce per ogni termine dell’interrogazione i documenti che lo contengono. È estremamente rapido, ma l’indicizzazione è molto complessa e costosa in quanto avviene utilizzando una tecnologia che si chiama Map Reduce dove i dati viaggiano molto sulla rete. Se il vector search fosse già una tecnologia efficiente quanto quella del file invertito sarebbe più facile indicizzare subito i documenti in vettori pronti poi per essere recuperati. Non solo, recupereremmo i documenti più semanticamente simili alla nostra interrogazione senza pesarli con modelli di pesatura più o meno complessi (RAG). Per questa ragione Google recupererà molto rapidamente il ritardo in termini di brand LLM su OpenAI, considerando che possiede tutte le tecnologie e i dati per svolgere in modo più incisivo e preciso il recupero di informazione rilevante per attività di ragionamento intelligente di tipo RAG.

In sostanza, per motivi di efficienza dobbiamo aspettarci che l’intelligenza artificiale sarà sempre più alla base della risoluzione dei problemi, senza che ciò implichi la rinuncia all’efficacia delle soluzioni non basate sull’AI. L’ostacolo principale al suo utilizzo nella ricerca è rappresentato dalla carenza di competenze e skill specifici, che in settori diversi dalla computing science (come per esempio le telecomunicazioni) risultano ancora limitati, impedendone al momento l’adozione e persino la definizione di una visione strategica per una sua integrazione nella ricerca. Inoltre, è necessario dotarsi di un’infrastruttura hardware costosa e poco scalabile, il cui accesso dovrebbe probabilmente essere garantito a livello europeo o nazionale.

Governare l’intelligenza artificiale: una necessità per l’efficienza e la sostenibilità delle organizzazioni

L’intelligenza artificiale sta rapidamente diventando una General Purpose Technology, che potrebbe trasformare radicalmente i processi decisionali, produttivi e di analisi delle organizzazioni pubbliche e private. Tuttavia, l’adozione dell’AI pone diversi problemi che occorre affrontare con tempestività al fine di renderla effettivamente sostenibile e utile. È necessario governarla con consapevolezza tecnica, visione strategica e responsabilità etica. L’approccio proposto nel presente approfondimento – fondato su una combinazione equilibrata di strumenti open, sviluppo interno controllato, valorizzazione e integrazione con gli LLM dei propri dati strutturati, orientamento verso architetture scalabili – offre un possibile percorso per valorizzare il potenziale dell’AI generativa e predittiva in ambito istituzionale, mantenendo il controllo sui processi e preservando la qualità dell’informazione. La sua attuazione richiede solide competenze, investimenti mirati e un forte coordinamento, che può restituire valore pubblico, efficienza operativa e trasparenza. Occorre però iniziare subito.